机器学习缺陷分类实验

发布时间:2025-07-03 08:21:01

点击数:0

信息概要

机器学习缺陷分类实验是针对机器学习模型在训练和推理过程中可能出现的缺陷进行系统性检测的项目。该实验通过第三方检测机构提供的专业服务,确保机器学习模型的可靠性、安全性和性能符合行业标准。检测的重要性在于能够及时发现模型中的偏差、过拟合、欠拟合、数据泄露等问题,从而避免在实际应用中产生严重后果,如决策错误、安全漏洞或法律风险。通过专业的检测服务,企业可以提升模型质量,增强用户信任,并满足合规要求。

检测项目

准确率, 精确率, 召回率, F1分数, 混淆矩阵, ROC曲线, AUC值, 训练损失, 验证损失, 过拟合检测, 欠拟合检测, 数据分布偏差, 特征重要性分析, 模型鲁棒性, 对抗样本测试, 计算效率, 内存占用, 响应时间, 模型可解释性, 公平性检测

检测范围

图像分类模型, 自然语言处理模型, 语音识别模型, 推荐系统模型, 目标检测模型, 时间序列预测模型, 异常检测模型, 强化学习模型, 生成对抗网络, 回归模型, 聚类模型, 降维模型, 神经网络模型, 决策树模型, 支持向量机模型, 随机森林模型, 贝叶斯模型, 集成学习模型, 迁移学习模型, 联邦学习模型

检测方法

交叉验证:通过将数据集分为多个子集,轮流作为训练集和测试集,评估模型性能。

混淆矩阵分析:通过统计模型预测结果与真实标签的对应关系,计算各项指标。

ROC曲线分析:绘制真正例率与假正例率的关系曲线,评估模型分类能力。

AUC计算:计算ROC曲线下的面积,综合评估模型性能。

对抗样本测试:通过生成对抗样本,测试模型在恶意输入下的鲁棒性。

特征重要性分析:通过统计或算法手段,评估各特征对模型输出的影响程度。

数据分布检测:分析训练数据与测试数据的分布差异,避免数据偏差。

模型可解释性测试:通过LIME、SHAP等方法,评估模型决策的可解释性。

公平性检测:检查模型对不同性别、种族等群体的预测结果是否存在偏见。

计算效率测试:测量模型在特定硬件上的推理速度和资源占用。

内存占用测试:评估模型运行时的内存消耗情况。

响应时间测试:测量模型从输入到输出的处理时间。

过拟合检测:通过比较训练集和验证集的性能差异,判断模型是否过拟合。

欠拟合检测:通过分析模型在训练集上的表现,判断模型是否欠拟合。

鲁棒性测试:通过添加噪声或扰动,测试模型在非理想条件下的稳定性。

检测仪器

GPU服务器, TPU加速器, 高性能计算集群, 内存分析仪, 网络分析仪, 数据采集卡, 逻辑分析仪, 频谱分析仪, 示波器, 信号发生器, 功率计, 温度传感器, 湿度传感器, 噪声发生器, 电压表

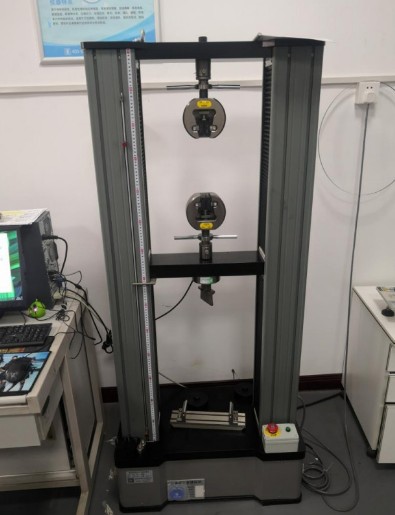

北检院部分仪器展示

北检(北京)检测技术研究院(简称:北检院),依托科研测试与材料检测重点领域,结合“211工程”和“985工程”建设,面向学校和社会企业开放的仪器共享机构和跨学科检测交叉融合平台。面向企业及科研单位跨学科研究、面向社会公共服务,构建具有装备优势、人才优势和服务优势的综合科研检测服务平台。

了解更多 +

北检(北京)检测技术研究院(简称:北检院),依托科研测试与材料检测重点领域,结合“211工程”和“985工程”建设,面向学校和社会企业开放的仪器共享机构和跨学科检测交叉融合平台。面向企业及科研单位跨学科研究、面向社会公共服务,构建具有装备优势、人才优势和服务优势的综合科研检测服务平台。

了解更多 +